Il presente articolo tratta il tema della stabilità dell’output di reti neurali in relazione al problema di Image Super Resolution, ossia il processo di ripristino di un’immagine ad alta risoluzione a partire da una versione corrotta a bassa risoluzione. Questo argomento è stato oggetto della tesi di Alessandro Alberti, intitolata Stability theory of Neural Networks for inverse problem with an application to Image Super Resolution, ed elaborata sotto la supervisione del prof. Marco Romito (Università of Pisa) e del dott. Nevio Dubbini (Miningful).

Seguendo gli studi condotti da V. Anthun, M. Colbrook e A. Hansen [2], i quali hanno dimostrato l’esistenza di una rete neurale per problemi inversi con proprietà di stabilità garantite dalla teoria elaborata, abbiamo adattato e sviluppato un approccio di deep learning per il problema di Image Super Resolution.

Questo problema viene modellato attraverso problemi inversi lineari tra spazi vettoriali a dimensione finita. In particolare, il problema consiste nel recuperare un vettore x da una misura y = Ax + e, dove A è un operatore di sub-sampling lineare ed e è un rumore bianco gaussiano. Questi operatori mappano vettori da uno spazio di dimensione superiore ad uno di dimensione inferiore, rappresentando il fatto che la misura y \in \mathbb{R}^m contiene meno informazioni rispetto al segnale originale x \in \mathbb{R}^N (N>m). Un approccio tipico al problema consiste nel riformularlo in termini del seguente problema di ottimizzazione:

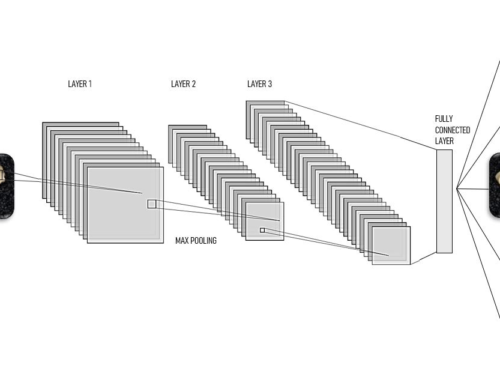

argmin_{x\in \mathbb{R}^N}\,\,\, \lambda\ \|x\|_{l^1} + \|Ax-y\|_{l^2}L’overfitting è strettamente legato alla instabilità di una rete neurale per questo tipo di problemi. Pertanto, le garanzie di stabilità sono ottenute imponendo alcune condizioni sull’algoritmo sviluppato al fine di prevenire l’overfitting nella soluzione. Il modello risultante è chiamato FIRENET (Fast Iterative REstarted NETwork, come in [2]). L’analisi teorica mostra come il tipico procedimento di addestramento delle reti neurali deep tenda a produrre metodi instabili. Pertanto, FIRENET ha una struttura di rete neurale feed-forward ma non necessita addestramento.

Per applicare questo modello all’Image Super Resolution, si è prima riformulato il problema in termini di un problema inverso lineare. Per fare ciò, si suppone che l’immagine di input a bassa risoluzione sia ottenuta mediante l’azione di un operatore di degradazione sull’immagine target ad alta risoluzione. Questo operatore aggiunge un effetto di sfocatura all’immagine e poi estrae un sottoinsieme dei suoi pixel. Durante l’analisi numerica, abbiamo costruito artificialmente le immagini a bassa risoluzione a partire dalle immagini ad alta risoluzione al fine

di confrontare l’immagine reale e l’immagine ricostruita da FIRENET.

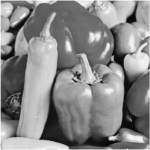

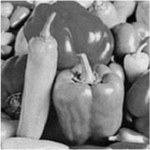

Negli esperimenti condotti abbiamo confrontato le prestazioni di FIRENET con quelle di un altro modello di ricostruzione, noto come interpolazione bicubica. Le immagini a bassa risoluzione sono state costruite sinteticamente affinché il numero di pixel dell’immagine a bassa risoluzione fosse 16 volte inferiore rispetto alla corrispondente immagine ad alta risoluzione. Inoltre, per gli esperimenti abbiamo utilizzato immagini in scala di grigi, affinché si potessero rappresentare con matrici a valori reali. Il problema e i modelli possono essere generalizzati al caso di immagini a colori considerando separatamente i tre strati RGB dell’immagine.

La figura 1 mostra i risultati ottenuti con l’immagine PEPPER: andando da sinistra a destra, le prime due figure raffiguarno l’immagine ad alta risoluzione e l’immagine sottocampionata e sfocata utilizzata come input per gli algoritmi di Super Resolution, mentre la terza e la quarta figura rappresentano le ricostruzioni ottenute rispettivamente con l’interpolazione bicubica e con FIRENET.

Fig. 1: Super Resolution dell’immagine PEPPER con misurazione priva di rumore. Da sinistra a destra: ground thruth; Input; Bicubic; FIRENET.

Questo primo test è stato condotto considerando misurazioni prive di rumore (e = 0) e l’analisi visiva ha evidenziato l’efficacia dell’algoritmo FIRENET nel ripristinare l’immagine attesa, rispetto all’interpolazione bicubica. Infatti, la figura più a distra appare decisamente meno sfocata rispetto sia all’input che all’immagine ”migliorata” attraverso l’interpolazione bicubica.

Quanto concluso vale anche in presenza di rumore nelle misurazioni, come mostrato dalla figura 2. Questo esperimento è stato condotto su immagini perturbate da rumore casuale, con due diverse magnitudini, di circa 1% (prima riga) e 2% (seconda riga). Questo rumore rappresenta un errore casuale nel metodo di misurazione, come quello generato dalla fotocamera utilizzata per catturare l’immagine.

L’analisi effettuata ha inoltre evidenziato come il tempo di elaborazione dell’immagine impiegato da FIRENET sia contenuto: il processo di Super Resolution di immagini a bassa risoluzione di 128×128 pixel richiede circa 9 secondi. Questa proprietà chiave suggerisce l’utilizzo di FIRENET come metodo di pre-processing per altri problemi di Imaging, come la classificazione di immagini effettuata su immagini a bassa risoluzione.

Fig. 2: Super Resolution dell’immagine PEPPER con rumori gaussiani di magnitudine ∼ 1%

Fig. 3: Super Resolution dell’immagine PEPPER con rumori gaussiani di magnitudine ∼ 2%

Per verificarne il potenziale, abbiamo sviluppato un modello di deep learnng per la classificazione di immagini e poi lo abbiamo testato sulle versioni ad alta risoluzione, sottocampionate e ”migliorate” con FIRENET. Per quest’ultima analisi, abbiamo considerato un problema di classificazione binaria sul dataset Dog-Cat e come algoritmo di classificazione è stata utilizzata una rete neurale convoluzionale addestrata sulle immagini ad alta risoluzione. Testando il modello su immagini ad alta risoluzione, si ottiene un’accuratezza del 91%, valore che però cala a 65% quando il modello è testato sulla versione a bassa risoluzione (artificialmente) corrotta delle stesse immagini. Tuttavia, quando testiamo il modello sulle immagini prodotte con FIRENET, l’accuratezza raggiunta è del 86%. Questi risultati confermano il fatto che FIRENET è in grado di recuperare le caratteristiche e i dettagli delle immagini ad alta risoluzione dalla loro versione corrotta e forniscono una misura aggiuntiva per quantificare l’incremento di risoluzione in termini del comportamento di un algoritmo addestrato automaticamente. Il lettore interessato può far riferimento a questa overview più tecnica, riguardante la costruzione di FIRENET e la teoria sottostante.

REFERENCES

Questo articolo è stato ottenuto a partire dalla tesi magistrale di Alessandro Alberti: Stability theory of Neural Networks for inverse problem with an application to Image Super Resolution (supervisor prof. Romito dell’Università di Pisa e dott. Dubbini di Miningful).

[1] Chambolle, Antonin and Pock, Thomas, A First-Order Primal-Dual Algorithm for Convex Problems with Applications to Imaging, Journal of Mathematical Imaging and Vision vol.40, pp. 120-145 (2010).

[2] Colbrook, Matthew J. and Antun, Vegard and Hansen, Anders C., The difficulty of computing stable and accurate neural networks: On the barriers of deep learning and Smale’s 18th problem, Proceedings of the National Academy of Sciences, vol. 119 (2022).[/fusion_text]